En muy poco tiempo la inteligencia artificial pasó de ser una promesa a convertirse en una realidad omnipresente. Hoy escribimos, diseñamos, analizamos y decidimos con apoyo de algoritmos que aprenden de millones de datos que no siempre comprendemos ni controlamos. La confianza en sus resultados crece más rápido que nuestra capacidad para entender cómo llegan a ellos, y ese desequilibrio se ha convertido en uno de los mayores desafíos tecnológicos y éticos de esta década.

Las organizaciones empiezan a depender de estos sistemas para clasificar información, evaluar candidatos, predecir fraudes o generar contenidos. Sin embargo, la mayoría no podría explicar con precisión qué modelo está detrás, con qué datos fue entrenado ni bajo qué controles opera. Esa confianza sin trazabilidad se ha vuelto el punto ciego de la nueva era digital:

Creemos en lo que produce la IA, pero no sabemos qué la alimenta.

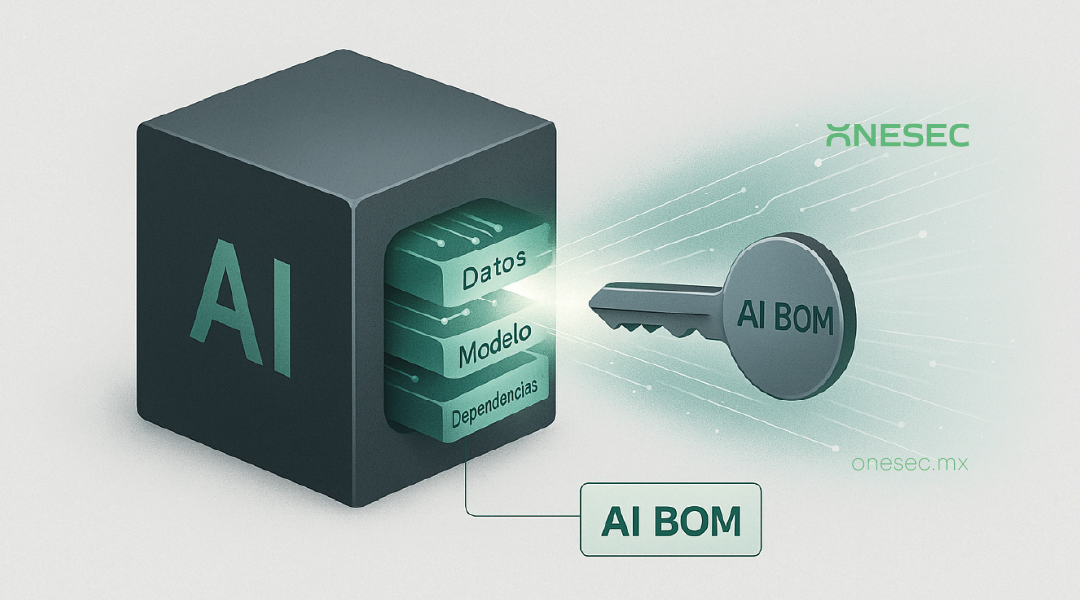

Y es justamente ahí donde surge el AI Bill of Materials, o AI BOM. Nace como respuesta a esa necesidad urgente de volver visible lo que se volvió invisible: la composición, el origen y el funcionamiento de la inteligencia artificial. Su propósito es crear un registro estructurado de todo lo que forma parte de un sistema de IA, desde los datos y modelos hasta las librerías, la infraestructura y los responsables que intervienen.

El concepto es reciente, pero está madurando con rapidez. En manufactura, un bill of materials garantiza que cada componente de un producto esté documentado antes de salir al mercado. En ciberseguridad, el Software BOM permite rastrear versiones y dependencias. El AI BOM aplica la misma lógica al ecosistema de la inteligencia artificial, pero con una diferencia esencial: aquí los componentes no son piezas ni líneas de código, sino datos, procesos y decisiones humanas.

El NIST AI Risk Management Framework, la ISO IEC 42001:2023, los Principios de la OECD y regulaciones europeas como el AI Act o DORA coinciden en una idea central:

La trazabilidad no es opcional.

En América Latina, el debate sigue la misma dirección. En México, el organismo Transparencia para el Pueblo (antes INAI), actualmente en proceso de transición administrativa y sectorizado bajo la Secretaría de Anticorrupción y Buen Gobierno, ha emitido lineamientos y criterios sobre decisiones automatizadas dentro del marco de la LFPDPPP, subrayando la importancia de la transparencia, la capacidad de explicación y la revisión humana, mientras avanzan propuestas legislativas para actualizar la ley frente al uso de inteligencia artificial. Brasil avanza con su Marco Legal de IA; Chile y Colombia desarrollan proyectos centrados en responsabilidad algorítmica y equidad; y Argentina ha incorporado la trazabilidad y la supervisión humana en su agenda digital. Todo apunta hacia una misma exigencia: las organizaciones deben poder demostrar de dónde provienen los datos, cómo se procesan y quién responde por los resultados que genera la IA.

Sin embargo, las regulaciones por sí solas no crean trazabilidad; si bien establecen principios, no establecen los mecanismos para cumplirlos; esa brecha entre lo normativo y lo operativo es precisamente donde el AI BOM adquiere relevancia. Permite transformar las obligaciones legales en evidencia práctica, convirtiéndose en la herramienta que une el discurso de cumplimiento con la realidad técnica de los modelos. A partir de ahí, el desafío no es legal, sino estructural.

Ahora, es muy improtante saber que no todos los modelos pueden documentarse con el mismo nivel de detalle:

Soluciones comerciales como Copilot, ChatGPT o Gemini operan bajo arquitecturas cerradas que impiden conocer la totalidad de sus datasets o parámetros.

En esos casos, el AI BOM no busca auditar lo inaccesible, sino documentar lo controlable: qué datos se comparten, qué dependencias se introducen, qué condiciones contractuales existen y qué medidas de mitigación se aplican. En cambio, los modelos desarrollados internamente, los agentes corporativos y las IA entrenadas con datos propios sí deben contar con un AI BOM completo. Es el equivalente moderno de una bitácora técnica: evidencia de responsabilidad, transparencia y control operativo.

Tambien debemos entender que las inteligencias artificiales no son todas iguales, y por tanto su trazabilidad tampoco lo es, por ejemplo, una IA descriptiva analiza y clasifica información; una IA generativa crea contenido nuevo, desde texto hasta imágenes o código; y una IA especializada automatiza decisiones de impacto directo, como diagnósticos médicos o aprobaciones financieras. En todas, el AI BOM cumple el mismo propósito: dejar constancia de los insumos, las condiciones y las consecuencias de cada modelo.

Aun así, cada tipo de IA exige un enfoque de cumplimiento distinto. Las mejores prácticas recogidas por el NIST AI RMF, la ISO IEC 42001, la OECD, la UNESCO y el IEEE definen seis principios que deben cumplirse en toda IA responsable:

- Privacidad. Los datos deben utilizarse de forma lícita, con consentimiento informado, y eliminarse o anonimizarse cuando su propósito haya concluido.

- Equidad. Los modelos deben evitar sesgos y garantizar resultados consistentes y justos en contextos equivalentes.

- Transparencia. Toda IA debe ofrecer información clara sobre su funcionamiento, propósito y limitaciones, sobre todo en decisiones que afecten personas.

- Capacidad de explicación. Los resultados deben ser comprensibles y justificables ante auditores, usuarios o reguladores.

- Seguridad y resiliencia. Los sistemas deben protegerse frente a manipulación, vulnerabilidades o usos indebidos, manteniendo integridad y disponibilidad.

- Supervisión humana. Ningún modelo debería actuar sin posibilidad de revisión o intervención humana.

En una IA descriptiva, estos principios se centran en el control de datos y la minimización de sesgos. En una IA generativa, se extienden a la trazabilidad del contenido, la verificación de derechos y la transparencia sobre las fuentes. En una IA especializada, el foco está en la capacidad de explicación, la validación de resultados y la revisión humana de decisiones críticas.

Cumplir con estos principios no es un requisito moral: es una condición operativa. Sin un AI BOM que documente datos, dependencias, accesos y controles, ninguno puede demostrarse de forma verificable.

Un AI BOM bien implementado permite responder preguntas que hoy muchas organizaciones evaden por desconocimiento:

- ¿Qué modelos existen realmente y quién los opera? El AI BOM crea un catálogo verificable de modelos, versiones, responsables y vínculos con procesos de negocio.

- ¿Con qué datos fueron entrenados y validados? Identifica origen, licencias, consentimiento, sesgos y calidad (asegurando además su correcta clasificación y protección bajo un marco de Data Governance).

- ¿Qué dependencias externas intervienen? Documenta librerías, APIs, frameworks y hardware para anticipar vulnerabilidades o impactos ante un cambio de proveedor.

- ¿Quién puede modificar los modelos? Registra aprobaciones, revisiones y controles de cambio, asignando trazabilidad a cada acción humana o automatizada.

- ¿Bajo qué políticas y normas operan? Relaciona cada sistema con los estándares y leyes que lo regulan, como ISO 42001, NIST AI RMF, LFPDPPP, GDPR o DORA, según el sector y la región.

Estas respuestas no son técnicas, son estratégicas. Demuestran que la IA no opera en un vacío, sino dentro de una estructura de responsabilidad y control que puede ser auditada y mejorada. Y como lo mencioné anteriormente, ya existen marcos, estándares y mejores prácticas que nos pueden apoyar. Los marcos internacionales no existen de forma aislada; todos comparten un propósito común: asegurar que la inteligencia artificial pueda ser comprendida, controlada y auditada.

Por ejemplo, el NIST AI RMF define cómo identificar, medir y mitigar riesgos algorítmicos. La ISO IEC 42001 establece controles formales para trazabilidad, transparencia y responsabilidad. Los Principios de la OECD promueven capacidad de explicación y rendición de cuentas. Y regulaciones como el AI Act o DORA traducen estos principios en obligaciones concretas para los sectores financiero, tecnológico y público.

Pero ningún marco por sí solo garantiza trazabilidad. Ahí es donde el AI BOM se convierte en el punto de integración. Funciona como el conector operativo que traduce las exigencias regulatorias en acciones verificables: documentar el ciclo de vida de los modelos, registrar los datos y dependencias, identificar responsables y mantener evidencia de cumplimiento. Sin ese registro, todos los marcos quedan en intención, no en práctica.

El AI BOM, bien implementado, es el lenguaje común entre la estrategia y la evidencia. Permite demostrar ante cualquier auditoría o autoridad que los principios éticos y normativos de la IA, como la privacidad, la equidad, la transparencia y la supervisión humana, no son solo declaraciones, sino realidades medibles dentro de cada modelo. Y una vez que podemos demostrar esa trazabilidad, el siguiente paso natural es integrar ese conocimiento dentro de un marco que ordene responsabilidades, decisiones y controles:

El Gobierno de IA.

El Gobierno de IA no sustituye a los marcos existentes: los integra. Es la evolución natural del Gobierno de Datos, del Gobierno de Identidades y de la Protección de la Información en entornos con inteligencia artificial. El primero define qué puede usarse y bajo qué condiciones, el segundo controla quién puede hacerlo y con qué privilegios y el tercero demuestra cómo esas identidades y esos datos se combinan dentro de los modelos y qué decisiones generan.

El AI BOM es el punto donde todo converge. Si el Gobierno de IA define el marco y las responsabilidades, el AI BOM aterriza esa estructura en evidencia concreta. En el ámbito de los datos, permite verificar que los conjuntos de entrenamiento y validación respeten las políticas de clasificación y uso legítimo. En el de las identidades, vincula cada acción con un responsable humano o de máquina, reforzando la segregación de funciones y la revisión periódica. Y en la protección de la información, aporta pruebas de que la privacidad y la confidencialidad se mantienen durante todo el ciclo de vida del modelo.

Su implementación no depende de tecnología nueva, sino de voluntad y disciplina. Comienza con un inventario básico, asigna responsables, define políticas de actualización y evoluciona hacia un proceso automatizado y auditable.

Para quienes desean iniciar de forma ordenada, cuatro pasos resultan particularmente útiles:

- Identificar los modelos de IA existentes y clasificarlos por nivel de impacto y sensibilidad.

- Documentar el origen y tratamiento de los datos que los alimentan (asegurando además su correcta clasificación y protección bajo un marco de Data Governance).

- Definir roles y responsabilidades claras, tanto humanas como automatizadas.

- Relacionar cada modelo con las normas y principios aplicables para asegurar coherencia con su marco regulatorio.

A partir de ahí, el AI BOM deja de ser una hoja de cálculo y se convierte en una práctica viva de gobernanza.

Gobernar la IA no significa frenarla o detener la innovacón, significa acompañarla con responsabilidad y acompañarla implica saber de qué está hecha, quién la alimenta, cómo evoluciona y qué impacto genera.

La verdadera confianza no está en lo que la IA acierta, sino en lo que somos capaces de explicar de ella. El AI BOM es esa explicación: la trazabilidad que la inteligencia artificial no tenía y que hoy define la frontera entre automatizar y gobernar.

Gracias por leer. Si este tema despierta dudas o te interesa explorarlo más a fondo, siempre estoy abierto a conversar y compartir perspectivas que puedan ayudar a tomar decisiones mejor informadas en materia de gobierno de IA.